Paper Reading: Embodied AI 10

从一些 Embodied AI 相关工作中扫过。

DeFM#

本文提出了 DeFM,一种完全基于深度图像训练的自监督基础模型,旨在为机器人应用提供几何和语义表示。该模型在包含 6000 万张深度图像的数据集上使用 DINO 风格的自蒸馏目标训练,并引入新颖的输入归一化策略以保持多尺度的度量意识。DeFM 在深度分类、分割、导航、运动和操作等基准上实现了最先进性能,展示了从仿真到现实环境的强泛化能力,同时可蒸馏为适合资源受限机器人系统的紧凑模型。

Sim-and-Human Co-training#

本文提出了 SimHum 协同训练框架,利用仿真和人类数据之间的互补性:仿真提供机器人动作的运动学先验,人类数据提供真实世界的视觉先验。基于这两种互补先验,该框架在相同数据收集预算下性能比基线提高高达 40%,在仅使用 80 个真实数据的情况下获得 62.5% 的 OOD 成功率,超越仅使用真实数据的基线达 7.1 倍。

ALRM#

本文提出了 ALRM(Agentic LLM for Robotic Manipulation),一个基于 LLM 的代理框架,通过 ReAct 风格的推理循环将策略生成与代理执行相结合。该框架支持 Code-as-Policy(直接生成可执行控制代码)和 Tool-as-Policy(迭代规划与工具执行)两种互补模式,并引入了涵盖 56 个任务的仿真基准。实验表明 Claude-4.1-Opus 是闭源最佳模型,Falcon-H1-7B 是开源最佳模型。

AC²-VLA#

本文提出了 AC²-VLA,一个面向 VLA 模型的动作上下文感知自适应计算框架,根据视觉观测、语言指令和先前动作状态来调节计算量。该框架在时间步间自适应执行认知重用、标记修剪和层选择性执行,并引入动作引导的自蒸馏方案实现跨任务的结构性稀疏化。实验表明 AC²-VLA 实现最高 1.79 倍加速,FLOPs 减少至密集基线的 29.4%,同时保持相当的任务成功率。

Demonstration-Free Robotic Control via LLM Agents#

本文提出 FAEA(Frontier Agent as Embodied Agent),直接将通用 LLM 代理应用于机器人操作,无需演示或微调。利用与软件调试相同的迭代推理方法,FAEA 使具身代理能够推理操作策略。在 LIBERO、ManiSkill3 和 MetaWorld 基准上分别实现了 84.9%、85.7% 和 96% 的成功率,接近使用少于 100 个演示训练的 VLA 模型水平。经过一次人类反馈后,LIBERO 上的性能提高至 88.2%。

TouchGuide#

本文提出了 TouchGuide,一种跨策略的视觉-触觉融合范式,在推理时分两阶段引导预训练的扩散或流匹配视觉运动策略。首先使用视觉输入生成粗略动作,然后通过接触物理模型(CPM)提供触觉引导以细化动作,确保满足物理接触约束。同时引入 TacUMI 数据收集系统,利用刚性指尖获取直接触觉反馈。在鞋带系和芯片交接等接触丰富任务上显著优于最先进的视觉-触觉策略。

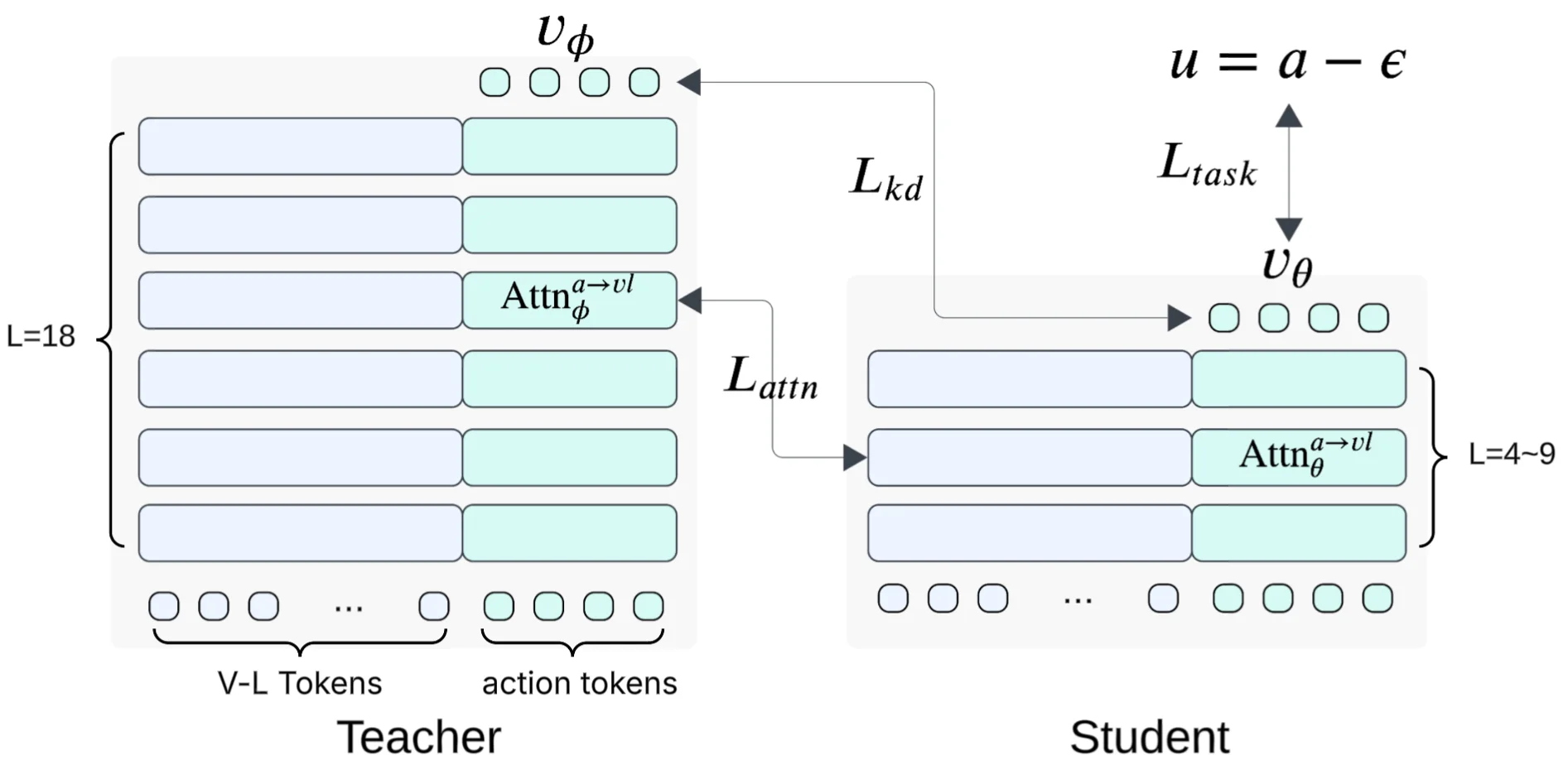

Shallow-π#

本文提出了 Shallow-π,一种知识蒸馏框架,通过积极减少 VLM 主干和流匹配动作头的 Transformer 深度(从 18 层压缩到 6 层),实现基于流的 VLA 模型的高效部署。该方法在标准操作基准上实现超过两倍的推理加速,成功率绝对下降不到 1%。通过在包括类人系统在内的多个机器人平台上的 Jetson Orin 和 Jetson Thor 进行工业规模真实世界实验验证了方法的有效性。

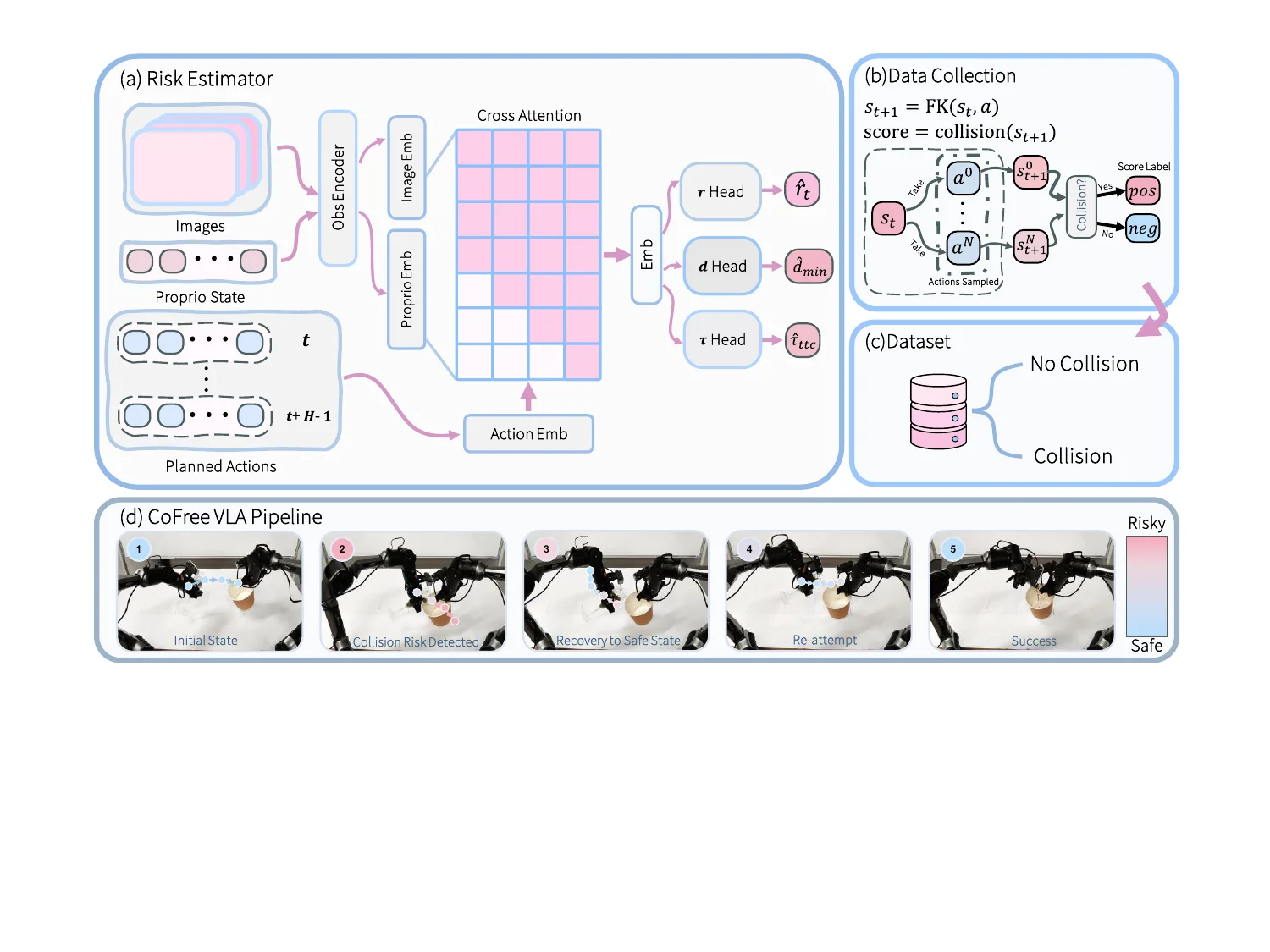

CoFreeVLA#

本文提出了 CoFreeVLA,通过短期自碰撞风险估计器增强端到端 VLA 模型,解决双臂操作中的自碰撞安全问题。该估计器根据本体感知、视觉嵌入和计划动作预测碰撞可能性,对高风险指令进行筛选,并通过风险引导的调整恢复到安全状态。在基于模型的碰撞标签上预训练,并在真实机器人操作中进行后训练校准。在 PiPER 机器人臂的五个双手任务中,CoFreeVLA 减少了自碰撞并提高了成功率。

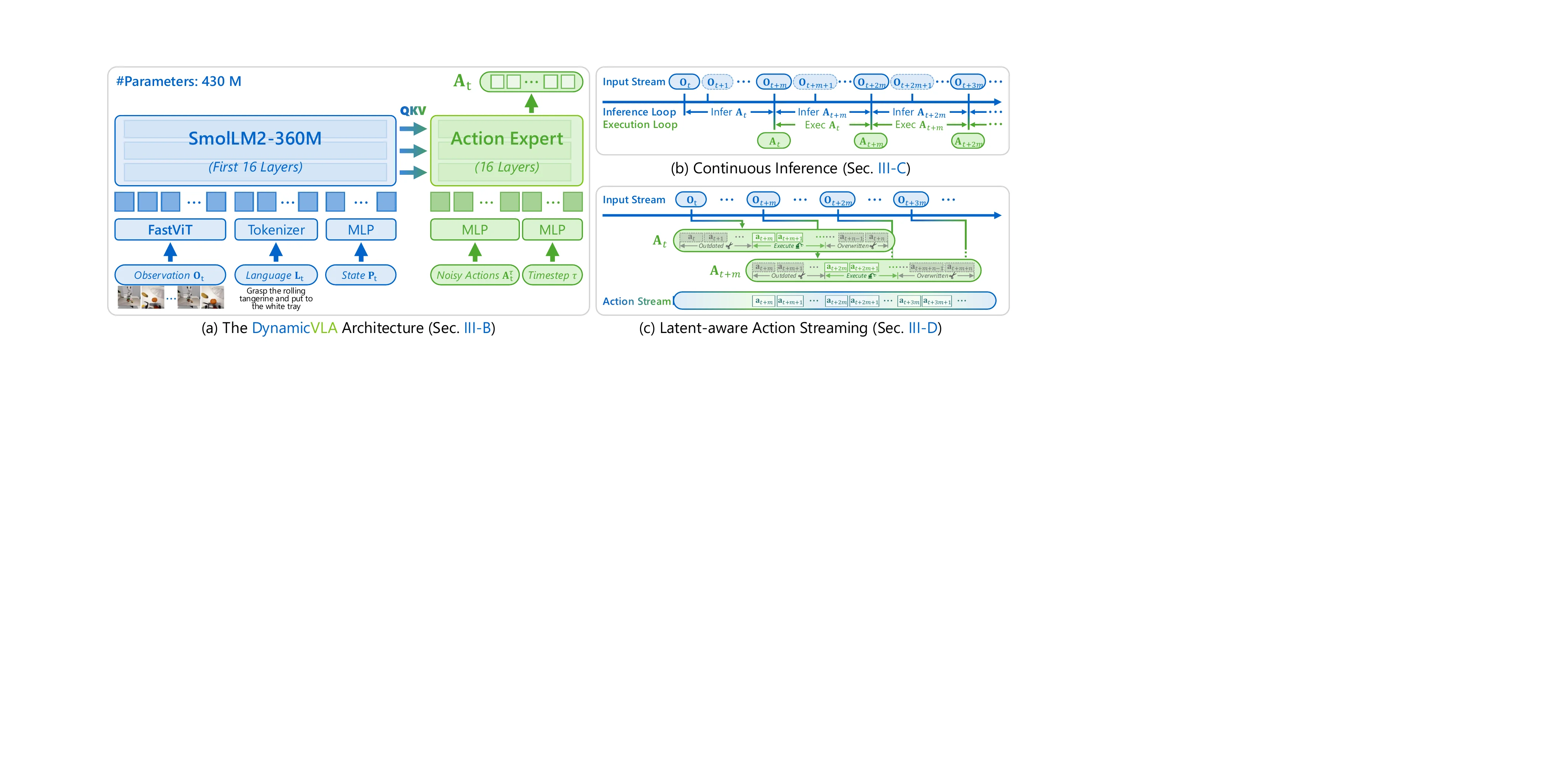

DynamicVLA#

本文提出了 DynamicVLA,一个专为动态物体操控设计的框架。该框架包含三项关键设计:紧凑的 0.4B VLA 使用卷积视觉编码器实现快速多模态推理;连续推理支持重叠的推理与执行以降低延迟;潜在感知动作流强制执行时间对齐的动作生成。同时引入动态物体操控(DOM)基准,包含 20 万条合成剧集和 2000 条真实世界剧集,在响应速度、感知和泛化方面取得显著改善。

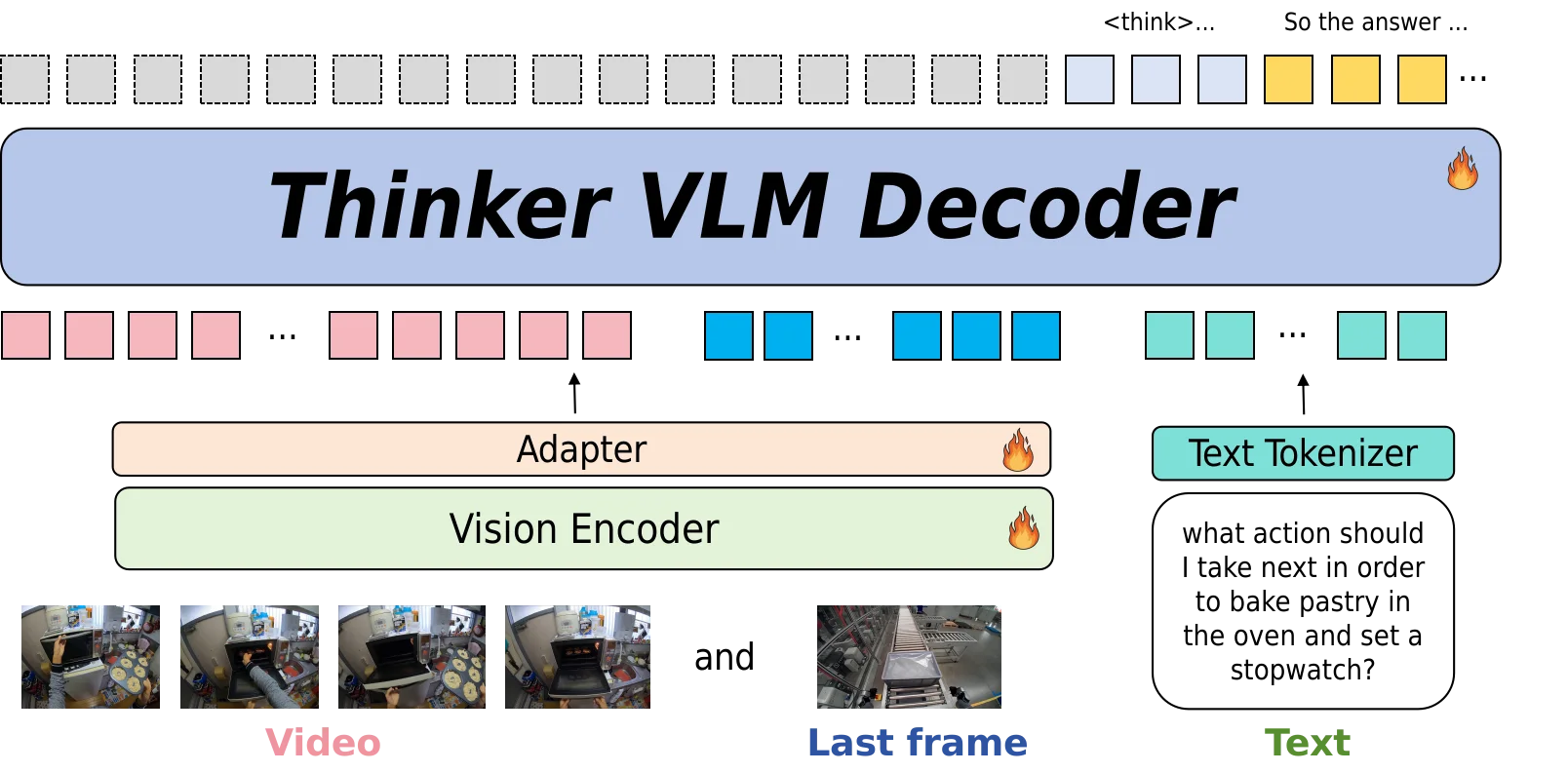

Thinker#

本文提出了 Thinker,一个专为具身智能设计的大型视觉-语言基础模型,解决现有模型在第一/第三人称视角混淆和视频时间推理中忽视末尾信息的问题。该模型构建了涵盖自我视角视频、视觉定位、空间理解和思维链数据的大规模数据集,并提出联合使用关键帧和完整视频序列作为输入的方法来增强视频理解能力。在任务规划领域最常用的基准数据集上达到了最先进结果。

FRISM#

本文提出了 FRISM(Fine-grained Reasoning Injection via Subspace-level model Merging),通过子空间级模型合并实现细粒度推理注入。该方法利用 SVD 对大型推理模型的任务向量进行分解,学习自适应调整每个子空间的缩放系数,并引入无标签自蒸馏学习策略进行双目标优化。实验表明 FRISM 在不妥协视觉能力的前提下有效提升推理能力,在各种视觉推理基准上实现最先进性能。

WheelArm-Sim#

本文提出了 WheelArm-Sim,一个在 Isaac Sim 中开发的合成数据收集模拟框架,用于轮椅安装机器人手臂(WMRA)的统一控制研究。该框架收集了包含操控与导航结合的多模态数据集(13 个任务、232 条轨迹、67,783 个样本),并在芥菜采摘任务中实现了动作预测的基线模型,证明了收集数据适用于集成控制的数据驱动机器学习模型。

Nimbus#

本文提出了 Nimbus,一个统一的具身合成数据生成框架,整合异构的导航和操作管道。该框架采用模块化四层架构,将轨迹规划、渲染和存储分离为异步阶段,并实施动态管道调度、全局负载均衡和分布式容错等优化。评估表明 Nimbus 在端到端吞吐量上比未优化基线提升 2-3 倍,并确保大规模分布式环境中的稳健长期运行。

DexTac#

本文提出了 DexTac,一个基于动觉教学的视觉触觉操作学习框架,直接从人类示范中捕获多维触觉数据(接触力分布和空间接触区域)。通过将丰富的触觉模态整合到策略网络中,灵巧手能够在复杂交互中自主选择和维持最佳接触区域。在单手注射任务上实现 91.67% 成功率,高精度场景中比仅依赖力的基线提高 31.67%。

LingBot-VA#

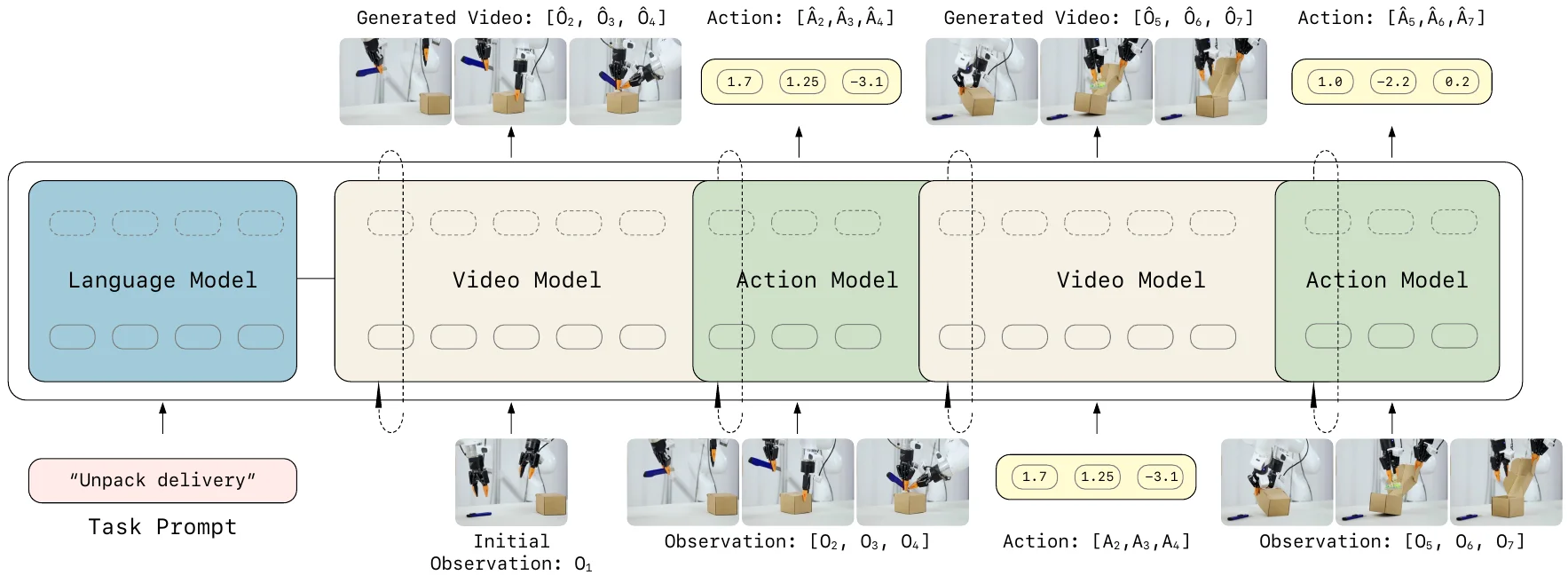

本文提出 LingBot-VA,一个自回归扩散框架,同时学习帧预测和策略执行,强调视频世界建模与视觉-语言预训练的结合为机器人学习建立独立基础。该模型具有共享潜在空间(MoT 架构驱动)、闭环回放机制和异步推理管道三项设计。在模拟基准和现实场景中展示了长时间操作、后训练数据效率以及对新配置的强泛化能力。

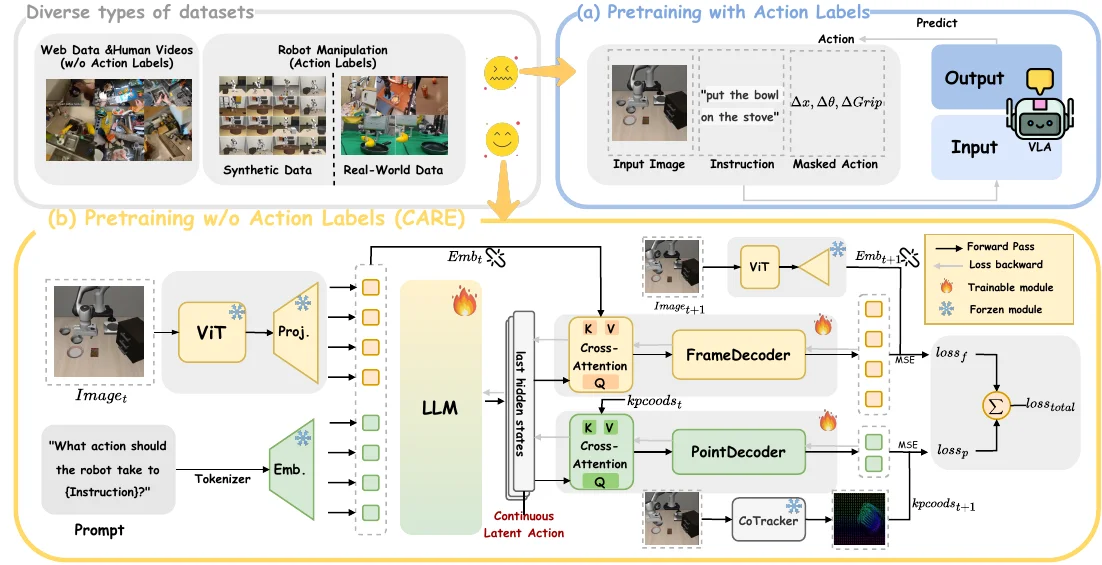

CARE#

本文提出了 CARE,一个通过仅利用视频-文本对来训练 VLA 模型的新框架,消除了预训练过程中对显式动作标签的需求。该方法通过新设计的多任务预训练目标学习连续的潜在动作表示,微调阶段仅需少量标记数据训练动作头。实验结果表明 CARE 在成功率、语义可解释性以及避免捷径学习方面表现优越,强调了弱监督下的可扩展性。

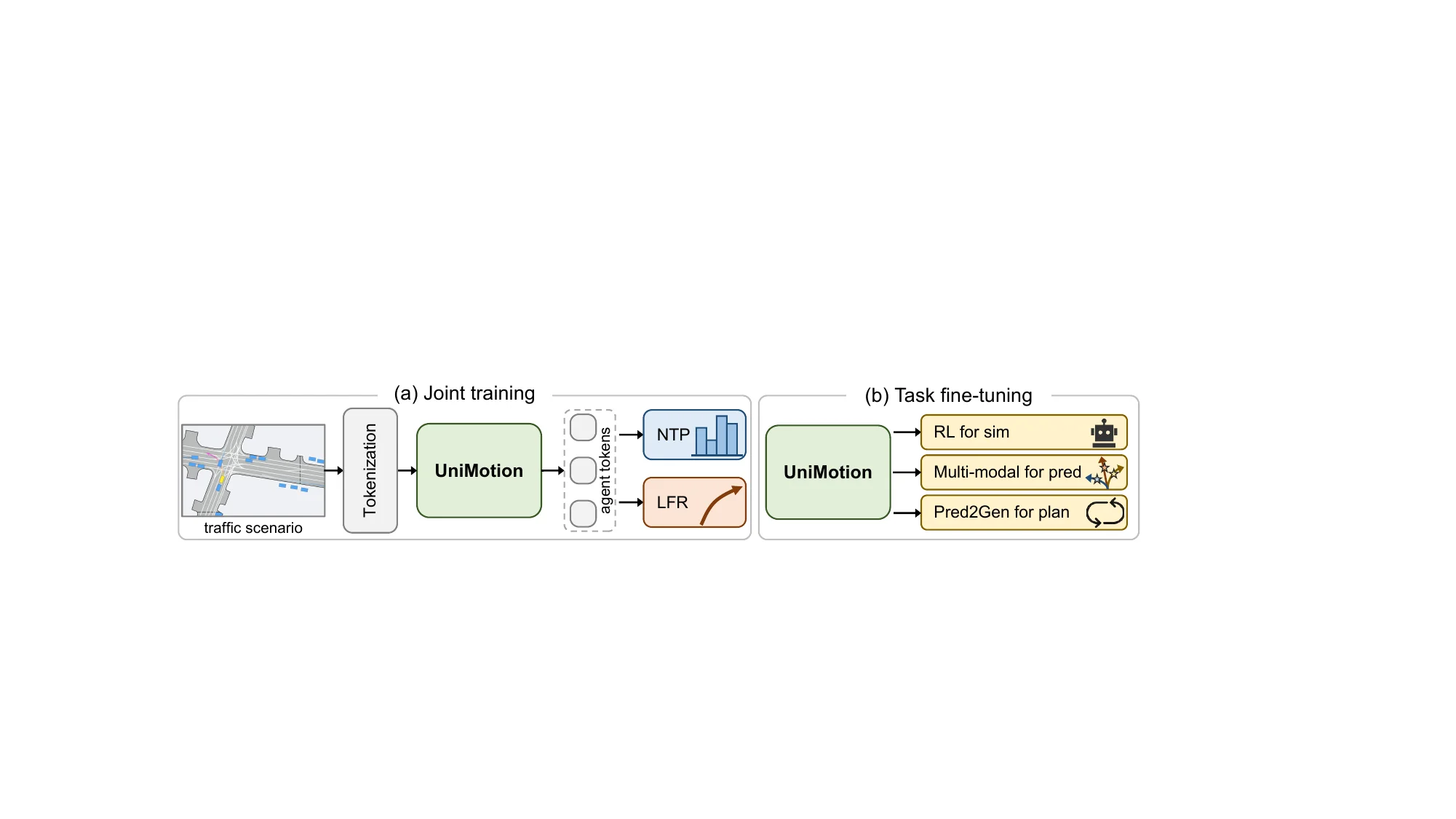

UniMotion#

本文提出了 UniMotion,一个统一运动框架,捕捉自动驾驶中仿真、预测和规划任务间的共享结构。基于仅解码器的 Transformer 架构,采用专门的交互模式和定制训练策略同时支持多种运动任务。在 Waymo 开放运动数据集上的实验表明,联合训练实现稳健泛化和有效任务集成,进一步微调后在各运动任务中达到最先进性能。

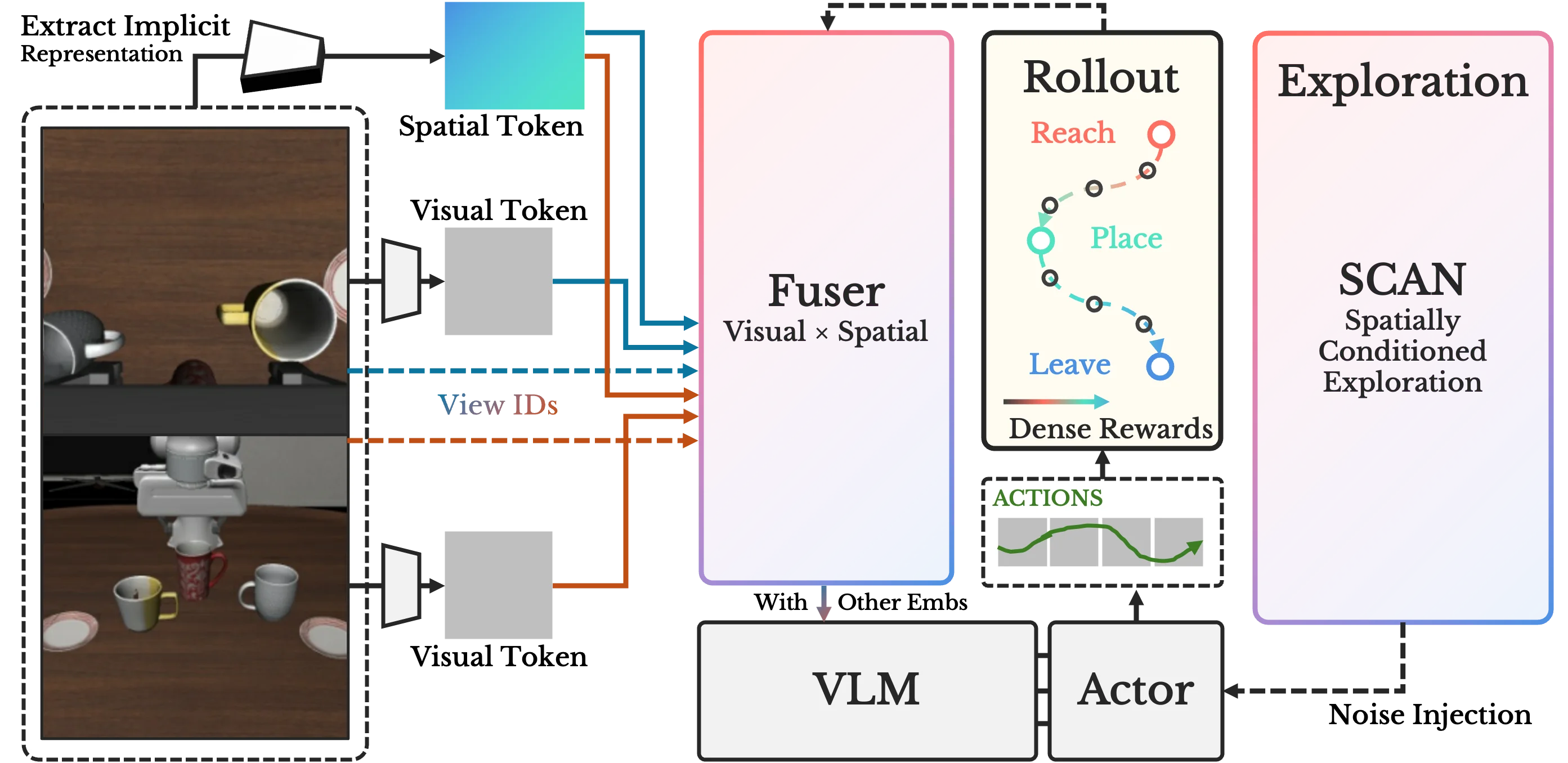

SA-VLA#

本文提出了 SA-VLA,一个空间感知的 RL 适应框架,解决流匹配 VLA 策略在强化学习微调后空间鲁棒性下降的问题。该框架将隐式空间表征与视觉标记融合,提供反映几何进展的密集奖励,并采用 SCAN(空间条件退火探索策略)适配流匹配动态。在多物体和杂乱操作基准中实现稳定的 RL 微调,并改善了零-shot 空间泛化。

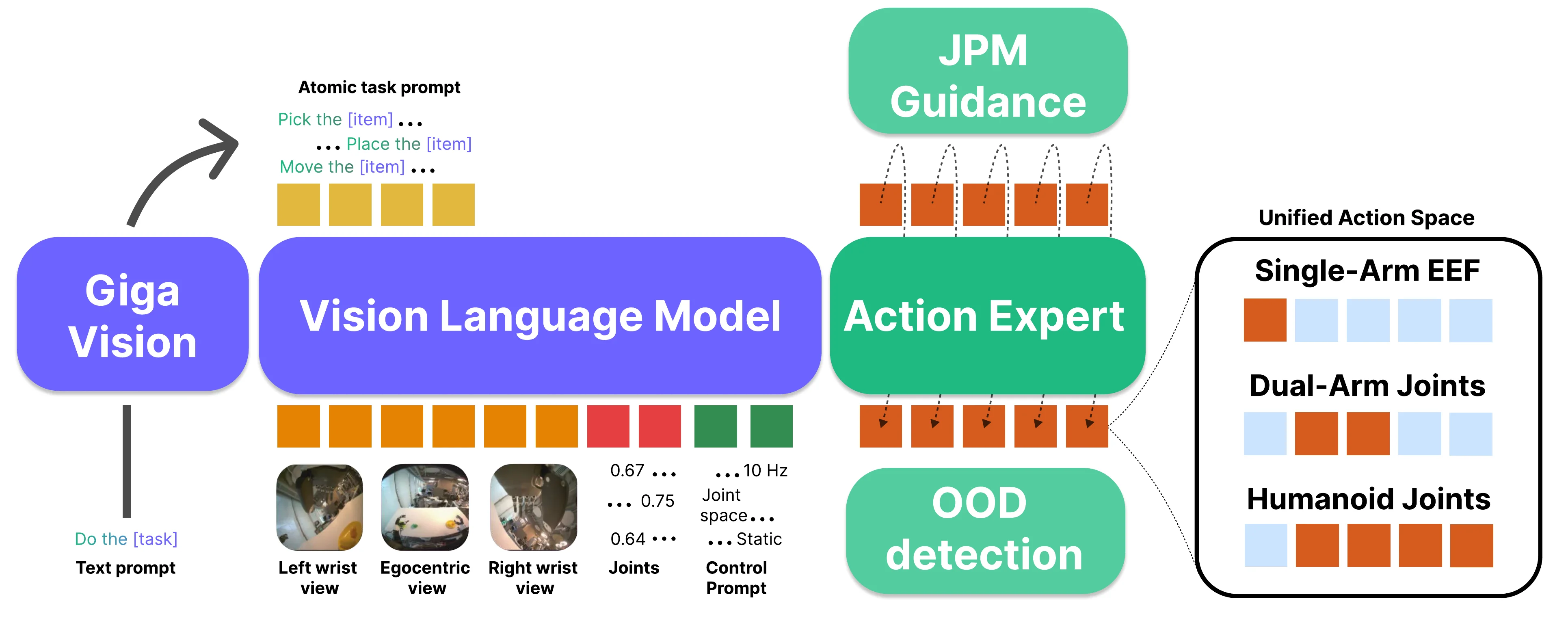

Green-VLA#

本文提出了 Green-VLA,一个分阶段的 VLA 框架,遵循五阶段课程(VLM 基础、多模态基础、多体现预训练、体现特定适应、RL 策略对齐),结合 3000 小时演示数据和统一的体现感知动作接口。推理时通过进度预测、OOD 检测和联合预测指导增强安全性。在 SIMPLER BRIDGE WidowX 和 CALVIN ABC-D 以及真实机器人上展示了强泛化和 RL 对齐带来的性能提升。

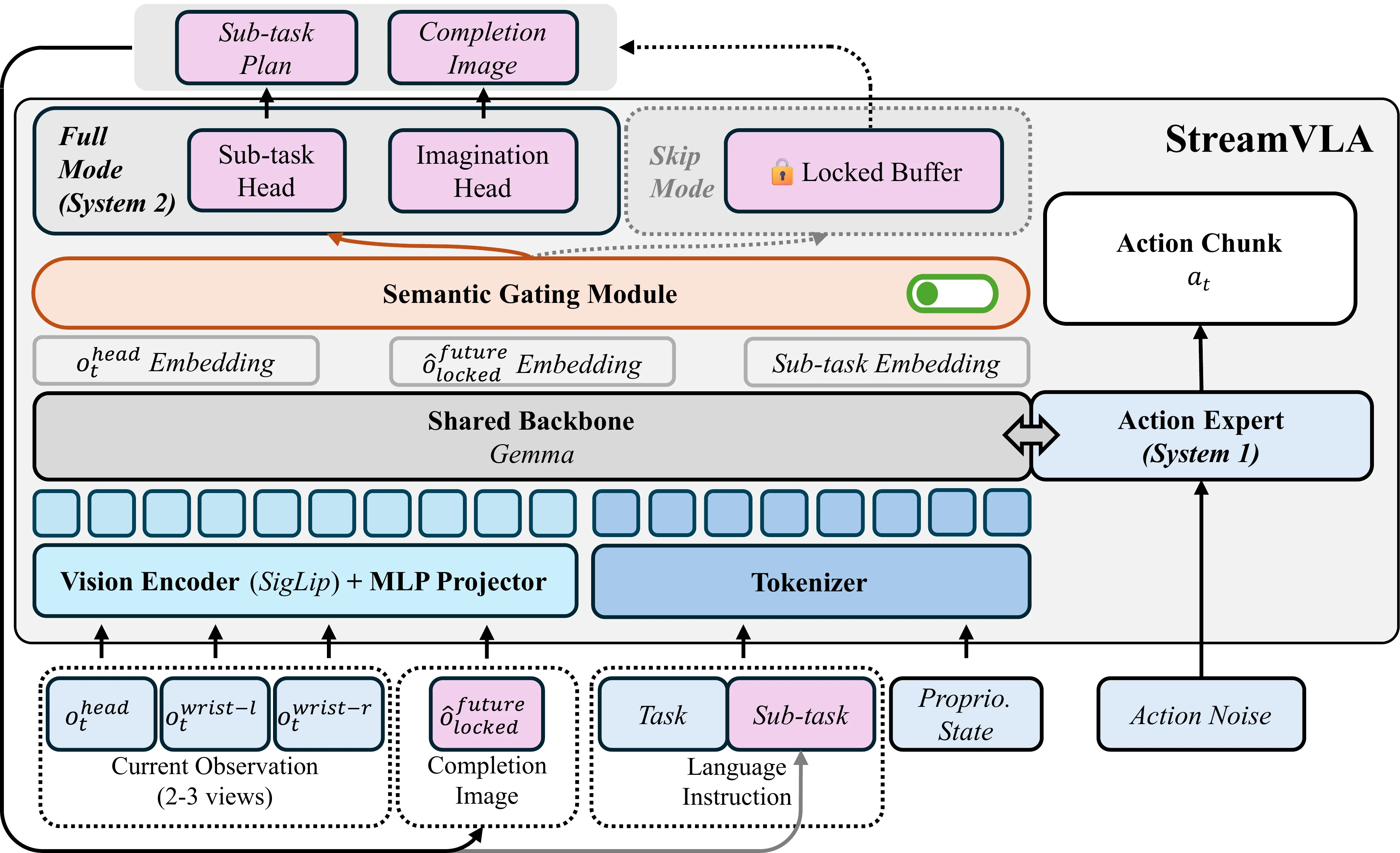

StreamVLA#

本文提出了 StreamVLA,一种双系统架构,统一了文本任务分解、视觉目标想象和连续动作生成。引入”锁定与门控”机制:仅在子任务转换时触发慢思考生成文本指令并想象视觉完成状态,该完成状态作为时间不变的目标锚点,使策略对执行速度变化具有鲁棒性。在稳定执行期间可绕过 72% 时间步的自回归解码,在 LIBERO 上实现 98.5% 成功率,延迟减少 48%。

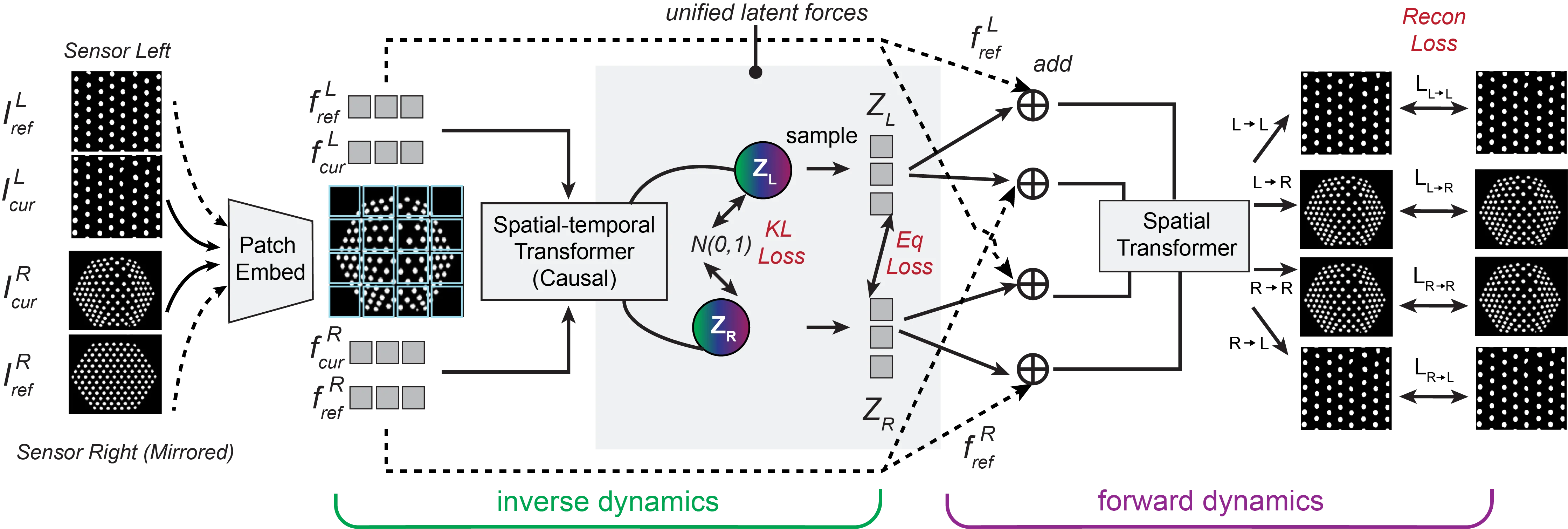

UniForce#

本文提出了 UniForce,一种统一触觉表征学习框架,能够在多样化触觉传感器间学习共享的潜在力空间。通过联合建模逆动力学(图像到力)和正动力学(力到图像),并利用静态平衡收集力配对数据实现跨传感器对齐。所得通用触觉编码器可零样本迁移至下游力感知任务。在 GelSight、TacTip 和 uSkin 等异质传感器上的实验表明力估计一致改善,并支持跨传感器的 VTLA 模型协调。

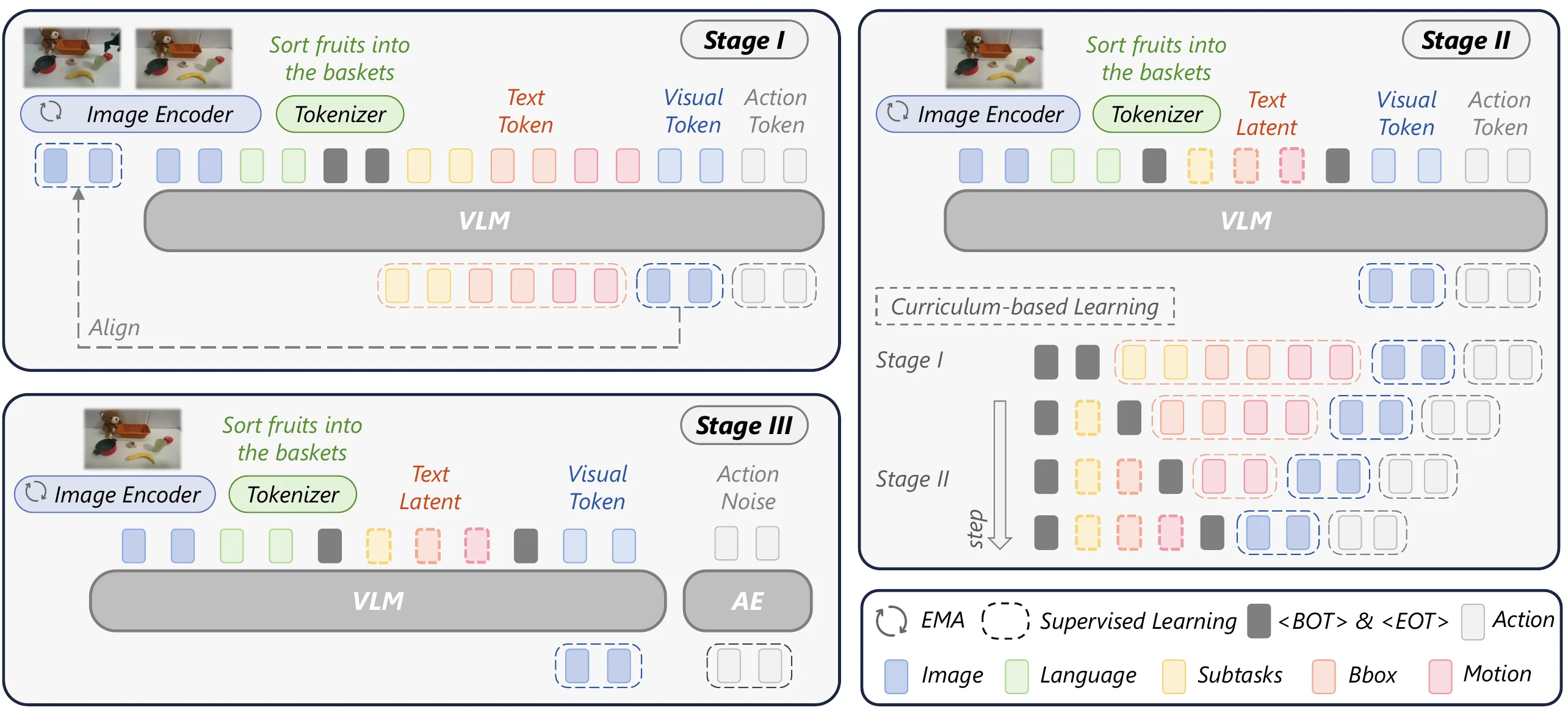

Latent Reasoning VLA#

本文提出了 LaRA-VLA,将多模态思维链推理内化为连续潜在表示,消除推理时显式 CoT 生成的需要。引入基于课程的训练范式,逐步从显式文本和视觉 CoT 监督过渡到潜在推理,最终调整潜在推理动态以条件化动作生成。实验表明 LaRA-VLA 性能优于最先进 VLA 方法,同时与显式 CoT 方法相比推理延迟减少高达 90%。

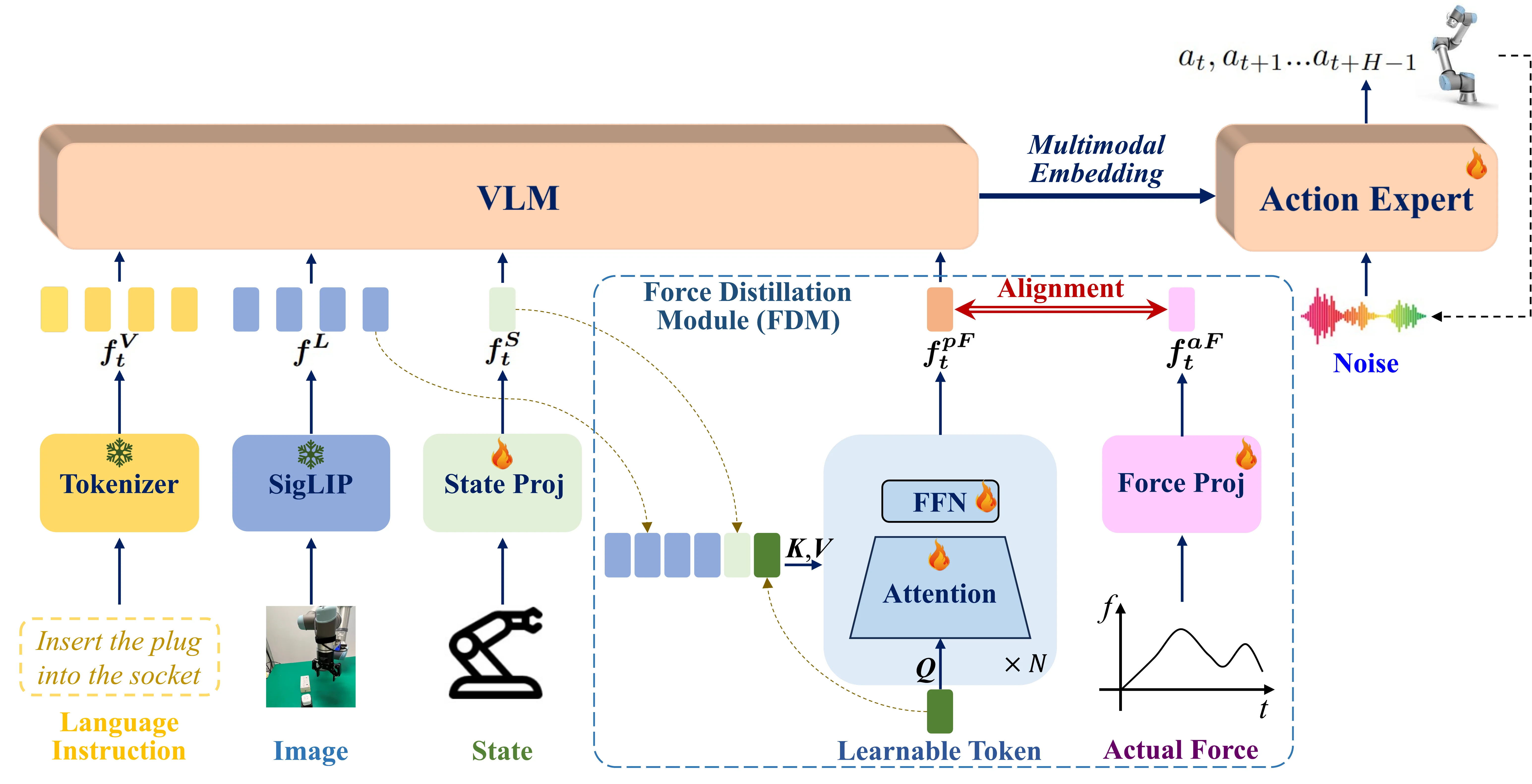

FD-VLA#

本文提出了 FD-VLA(Force-Distilled VLA),在不依赖物理力传感器的情况下将力感知集成到接触丰富操作中。核心力蒸馏模块将可学习查询令牌映射为与实际力信号对齐的预测力令牌,注入预训练 VLM 实现力感知推理。该设计降低了硬件成本,改善了跨模态对齐。实验表明蒸馏力令牌在性能上优于直接传感器力测量。

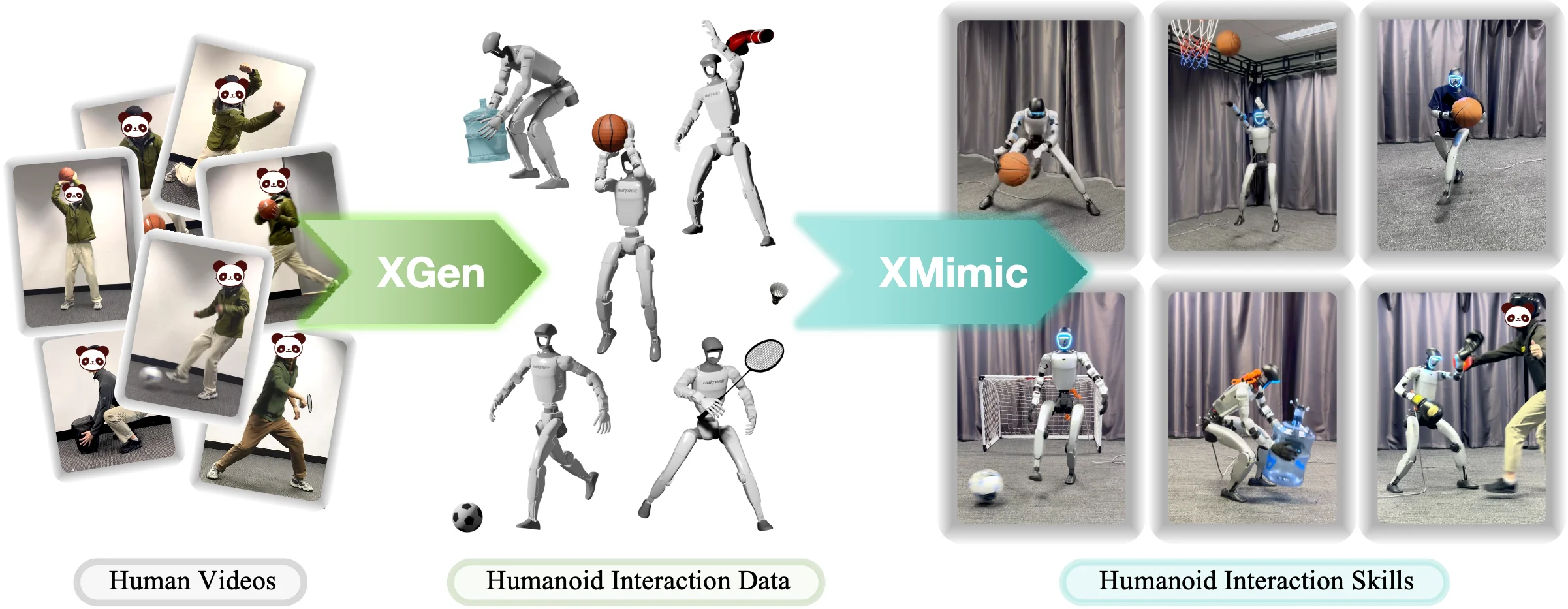

HumanX#

本文提出了 HumanX,一个将人类视频编译为可泛化现实世界交互技能的完整框架。包含 XGen(从视频合成物理合理的机器人交互数据并支持可扩展增强)和 XMimic(统一模仿学习框架)两个组件。在篮球、足球、羽毛球等五个领域评估,成功获得 10 种技能并零-shot 迁移到 Unitree G1 人形机器人,泛化成功率比先前方法高出 8 倍以上。

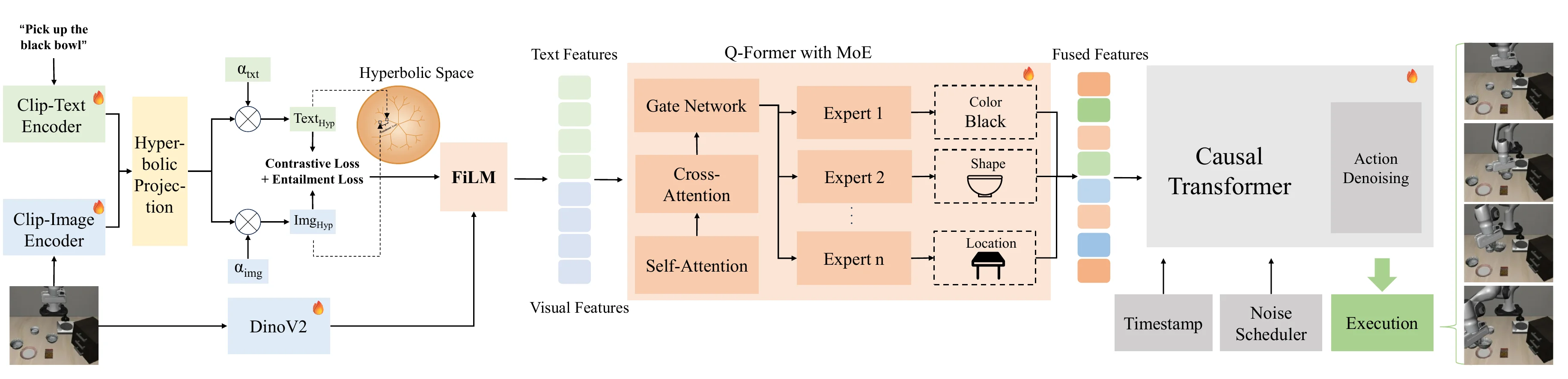

HMVLA#

本文提出了 HMVLA,一种利用视觉和语言中固有层次结构进行全面语义对齐的 VLA 框架。与传统欧几里得空间对齐不同,HMVLA 将多模态特征嵌入双曲空间以更有效建模层次关系,并引入稀疏门控 MoE 机制增强图像与文本间的多模态理解。实验表明 HMVLA 在准确性和泛化能力上超越基线方法,并通过重建数据集验证了跨领域适应性。

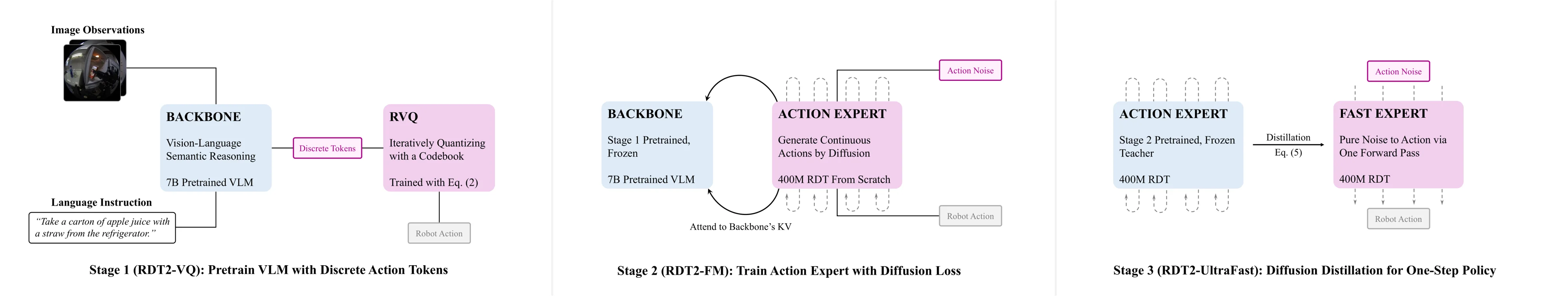

RDT2#

本文提出了 RDT2,一种基于 7B 参数 VLM 的机器人基础模型,旨在实现对新型体现的零-shot 部署。收集了超过 10,000 小时的多样化示范数据,采用增强的与体现无关的 UMI 接口,并设计三阶段训练方案(RVQ、流匹配、蒸馏)将离散语言知识与连续控制对齐。RDT2 成为首个能够同时对未见对象、场景、指令甚至机器人平台进行零-shot 泛化的模型之一,在打乒乓球等动态任务中超越最先进基线。